머신러닝 수업 프로젝트 (5) : 모델 및 하이퍼 파라미터 비교 실험

4. 실험 A. 실험 조건 이번 대회에서 사용한 데이터는 CINIC-10입니다. CINIC-10은 32x32 크기의 RGB 이미지 데이터로 각각 90,000장의 훈련, 검증, 테스트 데이터로 구성되어 있으며 비행기, 자동차, 새, 고양이, 사슴, 개, 개구리, 말, 배, 트럭 총 10개의 클래스로 구성되어있습니다. Figure 13은 CINIC-10 데이터의 예시를 보여줍니다. 실험 환경은 구글 코랩(Google Colab)이며, 그에 따라 GPU는 Tesla K80 또는 Tesla P100을 사용하였습니다. 실험에선 우선 최적의 성능을 나타내는 모델을 탐색하기 위해 기본적인 실험 조건을 설정했습니다. 하이퍼 파라미터인 학습률(learning rate)은 0.001, 배치 사이즈 (batch size)는..

머신러닝 수업 프로젝트 (5) : 모델 및 하이퍼 파라미터 비교 실험

4. 실험 A. 실험 조건 이번 대회에서 사용한 데이터는 CINIC-10입니다. CINIC-10은 32x32 크기의 RGB 이미지 데이터로 각각 90,000장의 훈련, 검증, 테스트 데이터로 구성되어 있으며 비행기, 자동차, 새, 고양이, 사슴, 개, 개구리, 말, 배, 트럭 총 10개의 클래스로 구성되어있습니다. Figure 13은 CINIC-10 데이터의 예시를 보여줍니다. 실험 환경은 구글 코랩(Google Colab)이며, 그에 따라 GPU는 Tesla K80 또는 Tesla P100을 사용하였습니다. 실험에선 우선 최적의 성능을 나타내는 모델을 탐색하기 위해 기본적인 실험 조건을 설정했습니다. 하이퍼 파라미터인 학습률(learning rate)은 0.001, 배치 사이즈 (batch size)는..

머신러닝 수업 프로젝트 (4) : 제안 방법

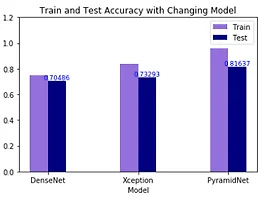

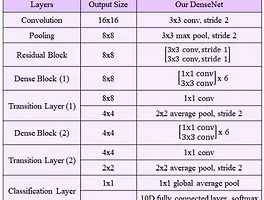

3. 제안 방법 본 연구에선 딥러닝 모델인 DenseNet, Xception, PyramidNet의 파라미터 수를 대회 규정에 맞춰 줄이기 위해, 그 구조를 일부 변경한 모델을 사용하고자 했습니다. 그다음, 같은 조건에서 각 모델을 학습시켜 최고의 테스트 정확도를 나타내는 모델을 선정합니다. 이후 실험을 통해 해당 모델에 맞는 최적의 하이퍼 파라미터 값을 찾아 적용한 후, 데이터 증강, Mish 활성화 함수, 앙상블 기법을 적용하여 더욱 향상된 성능을 얻고자 했습니다. A. 변형 DenseNet 원논문에서 제시한 DenseNet-121의 경우 Dense Block은 총 56개, Transition Layer는 총 3개이며, 파라미터 수가 약 1,300만 개에 이릅니다. 우리는 여기서 Dense Block..

머신러닝 수업 프로젝트 (4) : 제안 방법

3. 제안 방법 본 연구에선 딥러닝 모델인 DenseNet, Xception, PyramidNet의 파라미터 수를 대회 규정에 맞춰 줄이기 위해, 그 구조를 일부 변경한 모델을 사용하고자 했습니다. 그다음, 같은 조건에서 각 모델을 학습시켜 최고의 테스트 정확도를 나타내는 모델을 선정합니다. 이후 실험을 통해 해당 모델에 맞는 최적의 하이퍼 파라미터 값을 찾아 적용한 후, 데이터 증강, Mish 활성화 함수, 앙상블 기법을 적용하여 더욱 향상된 성능을 얻고자 했습니다. A. 변형 DenseNet 원논문에서 제시한 DenseNet-121의 경우 Dense Block은 총 56개, Transition Layer는 총 3개이며, 파라미터 수가 약 1,300만 개에 이릅니다. 우리는 여기서 Dense Block..